马斯克:搞不定AI5 特斯拉就完了

2026-02-11 19:04:28驾春秋1770717585

文 | HiEV大蒜粒车研所,作者 | 肖恩,编辑 | 德新

尽管马斯克在公开场合称之为「AI5 Chip」,但在特斯拉的工程定义里,它是 HW 5.0 —— 第五代车载计算平台。

2024 年 6 月,马斯克在 X 宣布 HW 5.0 改名为 AI5,沿用至今。时间来到 2025 年 11 月的股东大会上,马斯克说:“AI5 之后,不会再有下一代车载芯片了。”

无人驾驶、人形机器人、数据中心,全压这一个平台。他的原话是“Solving AI5 was existential to Tesla”——关乎存亡。

换句话说:搞不定,特斯拉就完了。

2025 年 6 月,一份疑似来自三星供应链的文档在韩国科技社区流出,列出了 AI5 的核心参数:

如果这些数字是真的,AI5 的性能逼近英伟达 H100。H100 卖 3 万美元,功耗 700 瓦,给数据中心用的。车载芯片做到这个水平?有点离谱。

特斯拉官方没有回应。马斯克自己在播客里开了口:"This is a beast. 这是一头怪兽。"

Q3 财报会,他给出了更多细节:

2026 年 1 月,马斯克在 X 上直接对标英伟达:

“单芯片大致是 Hopper 级别,双芯片是 Blackwell 级别,但成本极低,功耗也低得多。”

Hopper 推理算力约 4000 TOPS,功耗 700 瓦,而 Blackwell 算力翻倍到 9000 TOPS,功耗破千瓦。

泄露的数字,被一步步坐实了。马斯克吹过的牛很多,这次似乎有点靠谱。

(kfphwx.cn)

算力涨了 8 倍,推理性能却涨了 40 倍——中间差的 5 倍从哪来?答案是架构优化。

马斯克举了一个例子:神经网络里有个操作叫 SoftMax,用来算概率分布。在 HW4 上要跑 40 个步骤模拟;AI5 硬件原生支持,几步就搞定。一个操作省了三十几步,乘以网络里几百万次调用,5 倍的差距来自于这里。

更激进的是做减法。AI5 直接砍掉了 GPU 和图像处理器(ISP)。

先说 ISP。摄像头传感器输出 12-bit 原始数据,4096 级亮度。特斯拉以前的做法是先用 ISP 处理成“好看的图像”再喂给神经网络——去噪、调色、压缩,信息会有损失。

现在 FSD 绕过 ISP,从原始光子数据输入直接输出控制信号,信息更多,延迟更低。马斯克的原话是“我们不在乎图片好不好看,我们只要数据。”

再说 GPU。智驾芯片里的 GPU 通常干两件事:跑神经网络,渲染屏幕上的车道线和周围车辆。特斯拉把渲染扔给了座舱的 AMD Ryzen,FSD 芯片只干一件事:跑端到端神经网络。GPU 成了多余的面积,砍掉。

砍完之后,芯片面积缩到光刻机单次曝光的一半——马斯克管这叫「半个光罩」。面积小,成本就低,良率就高,发热就少。省下来的晶体管预算?全砸推理单元。

内存也在升级。HW3 用 LPDDR4,手机同款,带宽 70 GB/s。HW4 首次用了显卡内存 GDDR6,带宽拉到 384 GB/s。

泄露显示 AI5 带宽达到 1.9 TB/s。如果属实,大概率用的是 HBM3——H100 同款的高带宽内存,把好几层 DRAM 堆叠焊在芯片上。车载平台用 HBM,行业第一个。

马斯克的话中还透露了一个细节:AI5 会有单芯片和双芯片两个版本。

2025 年 6 月,马斯克透露特斯拉在测试一个 4 倍参数的新模型。两个月后他改口了:跳过 4 倍,直接上 10 倍。

"约 6 周后会有一个重大更新,参数量是原来的 10 倍。"

10 月,FSD v14 如期推送。

参数量涨 10 倍,算力、内存、带宽全得跟上。

参数涨 10 倍,计算量也涨 10 倍。但 FSD 不是云端慢慢算的语言模型—— 8 个摄像头、每秒 36 帧、360 度视野,必须在几十毫秒内给出判断。算力不够,要么丢帧,要么延迟,要么降精度。

HW4 的算力约 300 TOPS。v14 通过激进优化勉强跑起来了,但已经是极限。想跑更大的模型?想加入推理能力让车"思考"而不只是"反应"?算力不够。

推理能力是下一代 FSD 的核心升级。马斯克在 Q3 财报会上说,v14.3 会让车"有知觉"。以前的 FSD 是条件反射:红灯停,绿灯走。现在要做因果推理:前面那辆车减速可能要右转,右边有行人在犹豫,综合判断我应该变道降速。

这种“思考”不是一次计算就能完成的。多步推演,评估多个可能性,模拟未来几秒的场景。每多想一步,算力消耗就翻倍。

AI5 的推理性能是 HW4 的 40 倍。不是 8 倍、不是 10 倍,是 40 倍。多出来的部分,就是留给「思考」的。

神经网络的每个参数都要占内存。量化后,每 1 亿参数大约吃掉 100MB。v14 完整模型需要约 12.5GB。HW4 有 16GB,已经接近模型运行的下限。而 HW3 只有 8GB,只能跑精简版。

内存不只是装模型,还要装"记忆"—— 8 秒前那辆车在哪、行人往哪走、信号灯变了几次。特斯拉 AI 负责人 Ashok 说过,车载内存是限制上下文长度的主要瓶颈。想让车记得更久?先要把内存堆上去。

144GB,是 HW4 的 9 倍。够装更大的模型,还有余量留给更长的时间记忆。

光有内存还不够,还得喂得快。

神经网络推理时,每个参数都要从内存读到计算单元。模型跑一遍,参数读一遍。v14 模型约 12.5GB,每秒跑 30 次推理,每秒要读 375GB 数据。HW4 带宽 384 GB/s。刚好够。但也只是刚好。

模型再大 10 倍呢?每秒 3.75TB。HW4 的带宽无法支撑这样的规模。AI5 的 1.9 TB/s 带宽,就是为这个准备的。

(hxdean.com)

马斯克说,安全的无人驾驶需要 100 亿英里的训练数据。"现实世界的复杂性有超长的尾巴。"更大的模型才能装下这些长尾。

回头看 AI5:40 倍推理性能,9 倍内存,5 倍带宽。全是余量。

HW4 勉强撑住了 v14。AI5 是给下一个十倍准备的。

三、165亿美元的赌注

2025 年 8 月,三星和特斯拉签了一份 165 亿美元的代工合同。这是三星德州 Taylor 厂拿到的最大订单,也是特斯拉有史以来最大的芯片采购。

AI5 的制造策略在半导体行业几乎没有先例:同一颗芯片同时交给三星和台积电。

三星在德州 Taylor,用 3nm GAA 工艺;台积电在亚利桑那,用 3nm N3E 节点。马斯克公开说三星德州的设备比台积电亚利桑那「略微先进」。这话在半导体圈引起争议——台积电一直是先进制程的老大。

两家会生产“略有不同”的 AI5。工艺不同,但软件必须在两个版本上表现一致。

双代工是为了产能,FSD、Robotaxi、Optimus 全部压在 AI5 上。不能把鸡蛋放一个篮子里。

2026 年 1 月,三星 Taylor 厂开始测试 EUV 光刻设备——这是生产 3nm 芯片的关键一步。特斯拉确认了 AI5 的时间表:2026 年底少量产出,2027 年大规模量产。

但时间线也很“马斯克”。2025 年 7 月马斯克说设计“已经完成”,半年后改口“几乎完成”。熟悉的配方。直接的结果是 2026 年 6 月投产的 Cybercab 首发只能用 HW4。特斯拉最重要的新车,赶不上最重要的新芯片。

为了填这个坑,特斯拉悄悄推出了 HW4.5。

(ganxinyi.com)足球直播篮球直播NBA直播NBA直播足球直播

标签

相关推荐

新能源

新能源深耕者胜,长期者赢,smart的长期主义如何驱动“确定性增长”?-独家资讯

2026-01-2938

问答

问答极氪可以锁车不断电吗

2025-04-09311

用车

用车驾春秋-独家资讯

2026-02-1011

新能源

新能源二师兄玩车-独家资讯

2026-02-0235

驾春秋-独家资讯

2026-02-090

交通

交通求一首2017年4月份成都地铁宣传片BGM(背景音乐)! 最近在成都地铁上听(2017年成都地铁图)

2025-12-09426

交通

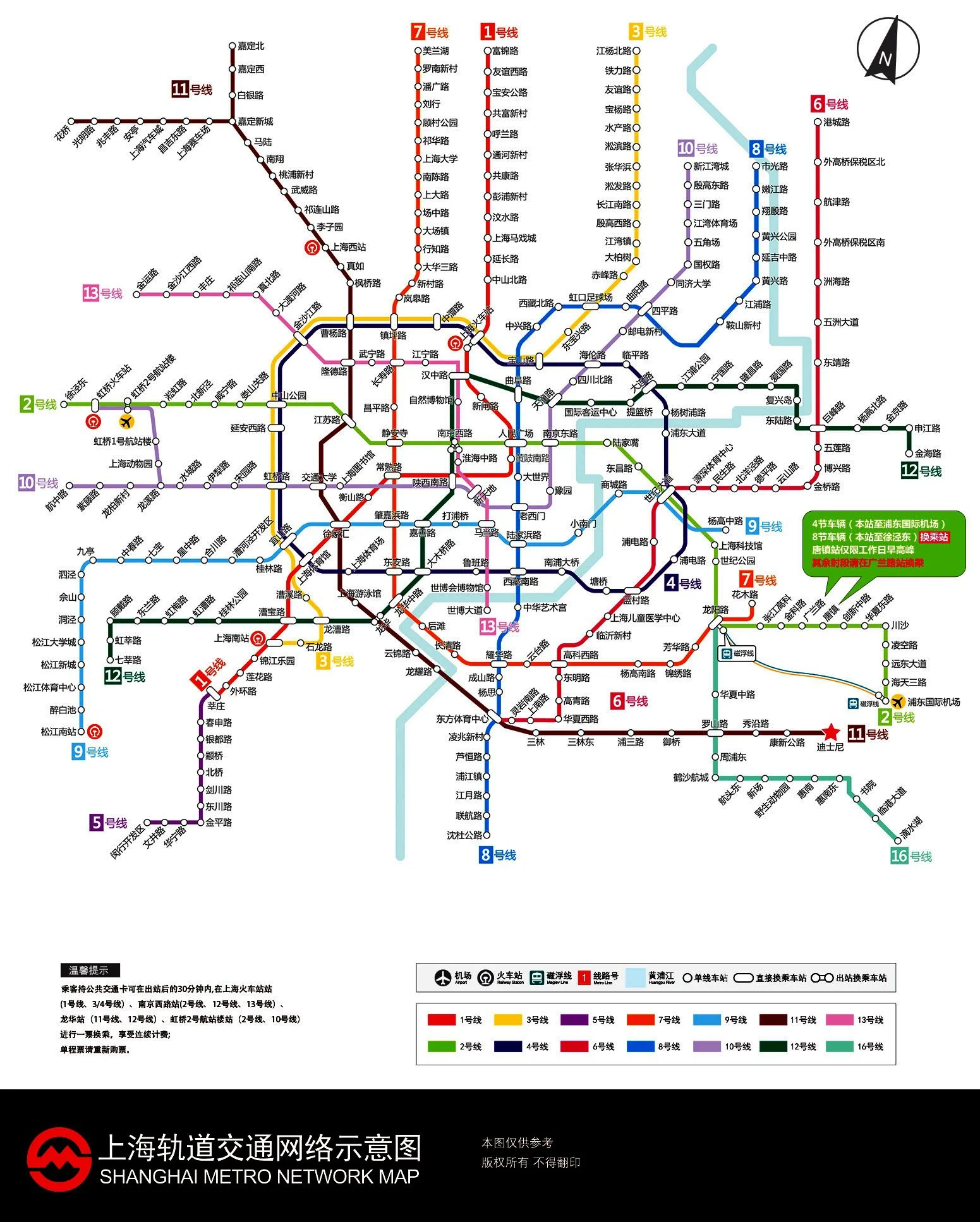

交通上海地铁11号线能够直达迪士尼吗(上海地铁11号线迪斯尼段)

2025-11-25468

新能源

新能源汽势家年华年度车——问界M9-独家资讯

2026-01-3039

体育

体育贝克汉姆遇到恶霸亲家 豪门联姻本是一场暗战

2026-02-0630

评论列表: